La ciencia de datos se ha convertido en una de las profesiones más demandadas y mejor remuneradas del siglo XXI. Combina estadística, programación, análisis de negocios y comunicación para extraer insights valiosos de los datos. Esta guía completa te llevará paso a paso a través de los fundamentos esenciales para comenzar tu carrera en este campo fascinante.

¿Qué es la Ciencia de Datos?

La ciencia de datos es un campo interdisciplinario que utiliza métodos científicos, procesos, algoritmos y sistemas para extraer conocimiento e insights de datos estructurados y no estructurados. Los científicos de datos trabajan con grandes volúmenes de información para resolver problemas complejos, predecir tendencias y apoyar la toma de decisiones basada en evidencia.

El proceso típico de ciencia de datos incluye la recolección de datos, limpieza y preparación, análisis exploratorio, modelado, evaluación y despliegue. Cada etapa requiere habilidades específicas y herramientas apropiadas. Los científicos de datos exitosos no solo dominan las técnicas matemáticas y computacionales, sino que también entienden el contexto de negocio y pueden comunicar sus hallazgos efectivamente.

Python: El Lenguaje Fundamental

Python se ha establecido como el lenguaje dominante en ciencia de datos debido a su sintaxis clara, extensa biblioteca de paquetes especializados y fuerte comunidad. Comenzar con Python es más accesible que otros lenguajes de programación, pero ofrece poder suficiente para proyectos complejos de nivel empresarial.

Las bibliotecas fundamentales incluyen NumPy para computación numérica, Pandas para manipulación de datos, y Matplotlib/Seaborn para visualización. NumPy proporciona arrays multidimensionales eficientes y operaciones matemáticas rápidas. Pandas introduce DataFrames, estructuras de datos similares a hojas de cálculo que facilitan enormemente el análisis de datos tabulares.

Fundamentos de Estadística y Probabilidad

La estadística es la columna vertebral de la ciencia de datos. Comprender conceptos como media, mediana, desviación estándar, correlación y distribuciones de probabilidad es esencial. La estadística descriptiva resume características de conjuntos de datos, mientras que la estadística inferencial permite hacer predicciones y generalizar resultados de muestras a poblaciones.

Los test de hipótesis permiten validar suposiciones sobre datos. El valor p, intervalos de confianza y significancia estadística son herramientas fundamentales para determinar si los patrones observados son reales o producto del azar. La comprensión de estos conceptos previene conclusiones erróneas y mejora la calidad de los análisis.

Manipulación y Limpieza de Datos

Se estima que los científicos de datos dedican el 70-80% de su tiempo a la preparación de datos. Los datos del mundo real son desordenados, incompletos e inconsistentes. La limpieza de datos incluye manejar valores faltantes, identificar y tratar outliers, normalizar formatos, y resolver inconsistencias.

Pandas ofrece herramientas poderosas para estas tareas. Métodos como fillna(), dropna(), replace() y merge() son fundamentales. La transformación de datos puede incluir agregaciones, pivotes, creación de nuevas características y codificación de variables categóricas. Un dataset limpio y bien estructurado es crucial para el éxito de cualquier análisis subsecuente.

Análisis Exploratorio de Datos

El análisis exploratorio de datos (EDA) es el proceso de investigar conjuntos de datos para descubrir patrones, detectar anomalías y verificar suposiciones mediante resúmenes estadísticos y visualizaciones. Esta fase es crucial antes de aplicar técnicas de modelado más complejas.

Las visualizaciones efectivas comunican información compleja de manera intuitiva. Los histogramas muestran distribuciones, los scatter plots revelan relaciones entre variables, los box plots identifican outliers y los heatmaps visualizan correlaciones. Bibliotecas como Matplotlib, Seaborn y Plotly proporcionan capacidades de visualización desde gráficos básicos hasta dashboards interactivos complejos.

Introducción al Machine Learning

El Machine Learning permite a las computadoras aprender de datos sin ser explícitamente programadas. Se divide en aprendizaje supervisado (con etiquetas), no supervisado (sin etiquetas) y por refuerzo (aprendizaje mediante recompensas). Scikit-learn es la biblioteca principal de Python para implementar algoritmos de ML.

Los algoritmos de aprendizaje supervisado incluyen regresión lineal para predecir valores continuos, regresión logística y árboles de decisión para clasificación. Random Forests y Gradient Boosting son técnicas de ensemble que combinan múltiples modelos para mejorar precisión. El aprendizaje no supervisado incluye clustering con K-Means para agrupar datos similares y PCA para reducción de dimensionalidad.

Evaluación y Optimización de Modelos

Un modelo que funciona perfectamente en datos de entrenamiento pero falla en nuevos datos sufre de overfitting. La división de datos en conjuntos de entrenamiento, validación y prueba es fundamental. La validación cruzada proporciona una evaluación más robusta del rendimiento del modelo.

Las métricas de evaluación dependen del tipo de problema. Para regresión, usamos MSE, RMSE y R². Para clasificación, precisión, recall, F1-score y AUC-ROC son esenciales. La optimización de hiperparámetros mediante Grid Search o Random Search busca la mejor configuración de parámetros del modelo. Feature engineering, la creación de nuevas características informativas, puede mejorar dramáticamente el rendimiento.

Deep Learning y Redes Neuronales

El Deep Learning, un subcampo del Machine Learning basado en redes neuronales artificiales, ha revolucionado áreas como visión por computadora, procesamiento de lenguaje natural y reconocimiento de voz. TensorFlow y PyTorch son los frameworks líderes para implementar modelos de deep learning.

Las redes neuronales consisten en capas de nodos interconectados que procesan información de manera similar al cerebro humano. Las redes convolucionales (CNN) son especialmente efectivas para procesamiento de imágenes, mientras que las redes recurrentes (RNN) y Transformers destacan en tareas de secuencias como traducción automática y generación de texto.

Herramientas y Plataformas

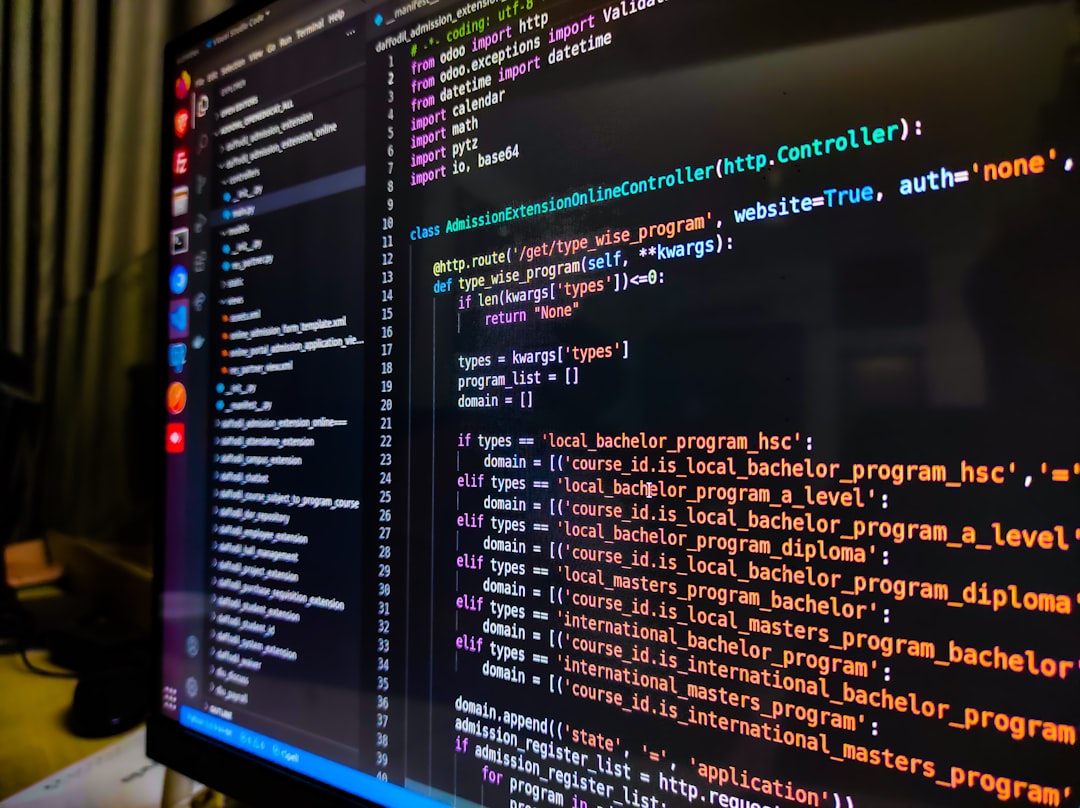

Jupyter Notebooks proporciona un entorno interactivo ideal para exploración de datos y prototipado. Permite combinar código ejecutable, visualizaciones y texto explicativo en un solo documento. Para proyectos más grandes, entornos de desarrollo como VS Code o PyCharm ofrecen funcionalidades avanzadas.

El control de versiones con Git es esencial para colaboración y seguimiento de cambios. Plataformas cloud como AWS SageMaker, Google Cloud AI Platform y Azure ML facilitan el entrenamiento y despliegue de modelos a escala. Containerización con Docker asegura reproducibilidad de entornos de desarrollo.

El Camino de Aprendizaje

Comenzar en ciencia de datos puede parecer abrumador dada la amplitud del campo. Una ruta de aprendizaje estructurada comienza con fundamentos de programación en Python, seguido de estadística básica y manipulación de datos con Pandas. Progresa a visualización de datos y análisis exploratorio, luego introduce conceptos de Machine Learning.

La práctica es crucial. Participa en competencias de Kaggle, trabaja en proyectos personales con datasets reales y contribuye a proyectos open source. Construye un portfolio que demuestre tus habilidades a potenciales empleadores. Las comunidades online como Stack Overflow, Reddit r/datascience y grupos de Meetup locales proporcionan apoyo y networking.

Conclusión

La ciencia de datos ofrece oportunidades extraordinarias para quienes estén dispuestos a invertir en aprendizaje continuo. Combina creatividad con rigor técnico, permitiendo resolver problemas reales con impacto medible. El campo evoluciona rápidamente, requiriendo curiosidad constante y adaptabilidad. En Cursos IT Profesionales, nuestros programas de ciencia de datos te guían desde los fundamentos hasta técnicas avanzadas, con proyectos prácticos que te preparan para una carrera exitosa transformando datos en decisiones inteligentes.